Et c’est ça qui est censé me remplacer? Il y a de la marge.

Et c’est ça qui est censé me remplacer? Il y a de la marge.

Société numérique (Digitale Gesellschaft) est une association suisse pour la défense des droits individuels sur internet. Elle est encore peu connue en Suisse romande, mais suffisamment prise au sérieux pour participer à des procédures de consultation au Parlement sur des questions telles que la neutralité du net et la réforme du droit d’auteur. Elle s’engage aussi contre la surveillance de masse, qu’elle soit étatique ou privée, avec les outils de la démocratie semi directe, ou le cas échéant devant les tribunaux, jusqu’à la Cour européenne des droits de l’homme. J’ai eu l’occasion de réaliser pour elle des traductions en français.

Société numérique organise également des événements publics. Le plus important est assurément son Congrès d’hiver (Winterkongress). En 2019, il s’est tenu le 23 février à Zurich. Voici un résumé de sa keynote, tenue par l’activiste allemande Katharina Nocun:

Ceux qui disent n’avoir rien à cacher connaissent-ils l’ampleur de leurs traces numériques? Afin de générer de telles traces, Katharina Nocun a utilisé pendant quinze mois un compte du géant du e-commerce Amazon. En y cherchant et en y achetant de tout, sans excès. Puis elle a demandé ses données liées à ce compte, comme le permet le Privacy Shield dont Amazon est signataire.

Après une certaine insistance, elle a reçu l’énorme fichier clickstream.xls, qui montre bien plus que ses achats: pour chaque connexion à Amazon, il indique un enregistrement de l’heure, du lieu, de l’adresse IP, des détails de sa session et de son navigateur, des adresses visitées (y compris d’où elle venait), du temps de chargement de la page, etc. En tout, cinquante variables. Soit, selon les termes (traduits) de Katharina Nocun:

Comme si quelqu’un nous poursuivait dans un supermarché et tenait un protocole pointilleux de quel chemin nous empruntons, de ce que nous regardons, et de quelles marchandises nous reposons sur le rayon.

(Keynote, slide 7)

D’après son clickstream.xls, sur les quinze mois de son test Amazon, Madame Nocun a généré plus de 15 000 enregistrements organisés selon cette cinquantaine de variables.

Ces données ne sont que celles qu’Amazon a bien voulu lui fournir. Mais elles suffisent à se demander quelle interprétation, et donc quel profil de personnalité, peut être tirée de ce « flot de clics »? Il ne s’agit pas seulement de ce qu’Amazon sait sur ses clientes, mais aussi de ce qu’il peut en déduire, à tort ou à raison. Considérons quelques achats de Katharina Nocun:

Madame Nocun est-elle une personne dangereuse? Ou est-ce que chacun de ses achats est explicable dans son contexte, qui échappe aux variables pourtant nombreuses du fichier clickstream.xls?

Quelles garanties existent que l’interprétation que peut faire Amazon — ou tout autre entreprise similaire qui tienne le couteau des données par le manche — ne soit pas partagée avec d’autres services ou organes, maintenant ou à l’avenir? Le cas échéant, quelles décisions seraient prises sur la base de cette interprétation à l’égard de l’ « interprétée », et quelles seraient leur légitimité et leur transparence? Pour rappel, les essais de crédit social chinois ont pour origine des systèmes de e-commerce.

Katharina Nocun a refait l’exercice avec plusieurs autres offres web et décrit avec humour les longues « correspondances amicales » qu’elle a dû entretenir avec nombre de services clients. Elle invite chacun-e à faire soi-même le test et demander ses données partout où on achète et consomme en ligne. Fun fact: Facebook tient un registre des « données effacées » pour chacun de ses comptes.

Parmi les autres thèmes du Congrès d’hiver: la portée, les détails et les abus de la surveillance étatique en Suisse; l’absurdité de vouloir bloquer les contenus à caractère pédopornographique en ligne plutôt que de les détruire (INHOPE); et la défiance légitime face au principe même du vote électronique. En attendant la prochain édition, voici toutes les vidéos du Winterkongress 2019.

Mise à jour (12 avril 2020): le podcast bien nommé The Privacy, Security, & OSINT Show a fait le même exercice pour Amazon et en décrit le résultat avec plus de détails techniques.

Hall central du centre des congrès de Leipzig lors du 34c3

La 34e édition du Chaos Communication Congress (34c3) s’est tenue à Leipzig du 27 au 30 décembre 2017. Le nombre de conférences et d’ateliers fut conséquent, et la variété des sujets abordés confirme la volonté des organisateurs de faire de leur congrès plus qu’une « simple » manifestation de hackers. Avec plus de 15 000 entrées payantes, cette volonté d’ouverture semble fonctionner.

Pas de grande révélation cette année, plutôt une multitude de petites idées et de confirmations. Bien que le slogan du 34c3 fut TUWAT (traduisible par « AGIS! »), de manière générale, on en est resté au niveau du diagnostic. Les solutions aux problèmes identifiés ne sont pas aisées, sans doute.

Deux thèmes ont eut droit à plusieurs conférence: l’exploitation des données personnelles par des entreprises ou des structures étatiques et ses conséquences, et les avancées de l’intelligence artificielle.

Une traduction en données de pratiquement tous les aspects de la vie est en cours. Les données personnelles deviennent des marchandises vendues par des data brokers comme Axciom et Oracle. Elles sont utilisées pour de la prédiction, mais aussi pour de la prise de décision.

Le manque de transparence semble être une constante chez les acteurs qui disposent de moyens importants de collecte et d’analyse de données, que ce soit la police au Royaume-Uni, les entreprises chinoises travaillant pour le compte de leur gouvernement, ou les grandes plateformes de médias sociaux pour ce qui est de leurs critères de censure. S’ajoutent à cela:

It’s not about your data, it’s about their derived data. – Tijmen Schep

Il existe une asymétrie de pouvoir entre d’un côté ceux qui ont la capacité de récolter des données en masse et d’agir à partir de ces données, de l’autre les personnes dont les données sont exploitées, qui subissent une perte de contrôle.

Sans connaître en détails ces pratiques, de plus en plus de gens s’en doutent bien. Ils/elles communiquent moins et se censurent par peur de conséquences négatives (social cooling). Par ailleurs, une étude représentative montre qu’une grande majorité des citoyens européens souhaite que les outils de communication soient respectueux par défaut de la sphère privée.

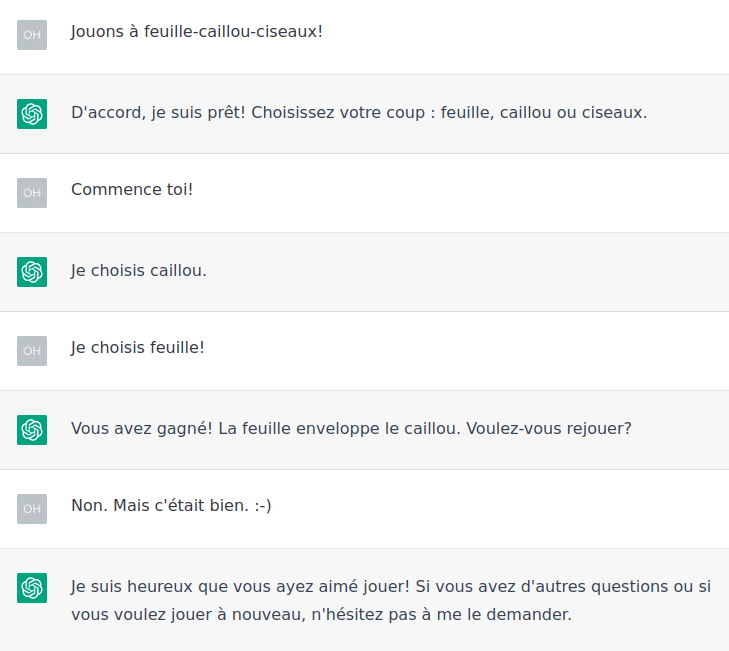

Un zoetrope en 3D exposé au 34c3

Les risques évoqués ci-dessus se retrouvent dans le traitement de telles données via l’intelligence artificielle. Les biais y sont omniprésents et mènent à de la « discrimination 2.0. ». Exemple: une recherche sur Google Images pour « three white teenagers » montrera trois jeunes souriants, alors que « three black teenagers » proposera trois portraits de jeunes suspectés de crime. Que ce soit voulu ou non, cela crée un effet de prophétie auto-réalisatrice.

Ces biais sont dus aux données qui influencent le modèle et/ou au modèle qui se répercute sur les données.

Exemple de biais de données: une étude chinoise affirme pouvoir reconnaître des criminels d’après les traits du visage. Or, les photos utilisées pour identifier « les gentils » sont tirées de dossiers de candidature, où les portraits sont sous leurs meilleurs jours, quand ils ne sont pas franchement retraités avec Photoshop.

Les biais de modèles se basent sur des suppositions simplifiées, qui ne sont souvent ni nommées ni vérifiées. Quand trop peu de contexte est disponible, respectivement trop peu de scénarios ont été testés, l’intelligence artificielle se base sur des suppositions: un médecin sera plutôt un homme qu’une femme, etc. Elle cherchera des corrélations, mais ne sera pas en mesure de déterminer causes et effets.

Ces types de biais existaient déjà dans la statistique. Tout cela n’est pas foncièrement nouveau, mais se trouve massivement renforcé par les capacités actuelles de calcul et les masses de données à disposition (Exemple: Google Mail a un milliard d’utilisateurs). La nouveauté est aussi que beaucoup d’argent est fait avec ces biais!

Artificial intelligence is powerful, but not mystical. – Katharine Jarmul

Connaître ces biais permet aussi de tromper une intelligence artificielle, par exemple en « empoisonnant » les données de test pour faire augmenter le taux d’erreur. Les applications pratiques: s’évader de la surveillance, tromper les systèmes de publicité, créer de fausses données personnelles, …

Que les données personnelles soient exploitées par de l’intelligence artificielle ou non, plusieurs intervenants mettent beaucoup (trop?) d’espoir dans les mécanismes légaux de défense induits par le règlement général sur la protection des données (RGPD), dont le respect sera bientôt obligatoire pour tout service agissant dans l’Union européenne. Apparemment, l’ordonnance y relative va dans la bonne direction.

Une marque de fabrique du Chaos Communication Congress est la dénonciation, preuves techniques à l’appui, de la sécurité défaillante voire inexistante d’infrastructures de services. Cette année, ce sont entre autre les bornes de chargement pour véhicules électriques et les applications mobiles des banques allemandes qui s’en sont pris pour leur grade.

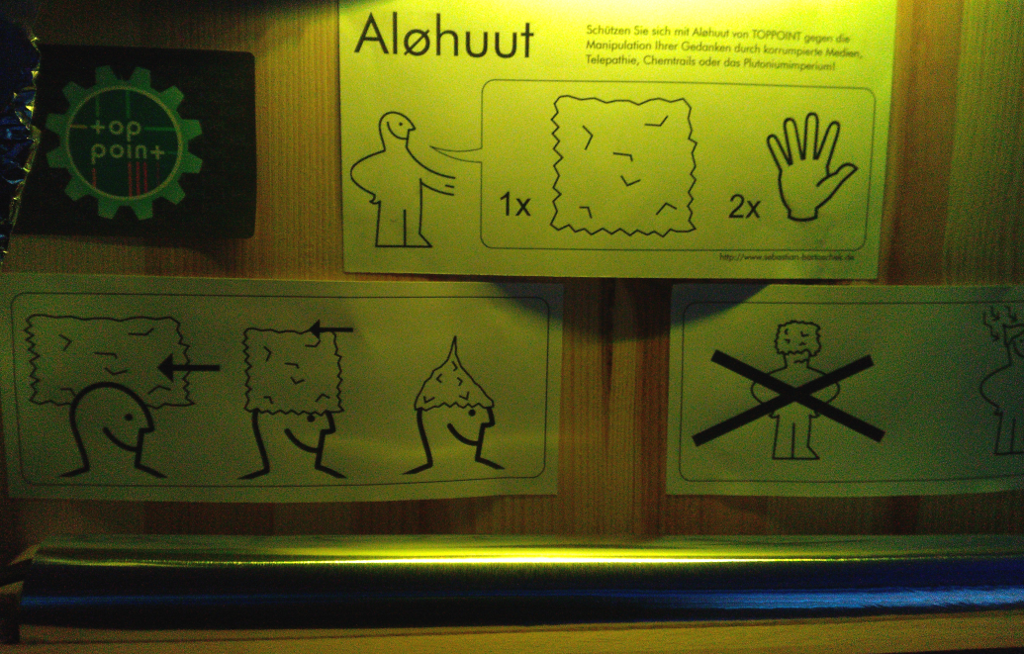

Instruction pour un chapeau en aluminium, inspirée par un grand fournisseur de meubles suédois

Quelques courtes infos (avec les vidéos des conférences dont elles sont tirées en lien):

The Chinese government do not count and think in years – they think in decades, at least. – Katika Kühnreich

Personnes, outils et organisations à suivre:

À tort ou à raison, c’est avec les commentaires sur l’accession de Donald Trump à la présidence des États-Unis que la notion de bulle de filtrage est parvenue dans le grand public. Nous sommes toutes et tous « otages » de notre passé sur le Web, à un degré ou à un autre. Les services en ligne que nous utilisons pour chercher et/ou recevoir de l’information l’adaptent selon la manière dont nous avons utilisé ces mêmes services par le passé. Pour un moteur de recherche, ce sera entre autre l’historique de recherche. Pour un réseau social, ce sera entre autre nos connections aux autres utilisateurs. Cela vaut pour tout service web pour lequel une inscription à un compte est requise. Mais notre bulle de filtrage personnelle se construit au-delà de nos comptes web: cookies, pixel espion, empreinte audio…

La plupart du temps, les services web affirment collecter les données d’utilisation pour « améliorer l’expérience de l’utilisateur », à savoir lui livrer des informations qui sont personnalisées pour lui seul. Pour ces services, le but ultime est que les utilisateurs restent ou reviennent le plus souvent possible chez eux. Cela peut avoir des avantages aussi pour les utilisateurs. Par exemple, refind est un bon service pour découvrir des contenus par rapport à ceux qu’on a déjà sauvegardés. Mais les dangers pour la formation d’une opinion, par exemple, sont évidents. Si, sur la base de mon historique d’utilisation, mon moteur de recherche ne me livre que des informations avec lesquelles je suis d’accord, puis-je me considérer vraiment informé?

Qui plus est, la manière dont fonctionnent les analyses et algorithmes qui délivrent ainsi les données aux utilisateurs est la « formule du Coca-Cola du 21e siècle ». Pour qui n’est pas dans le secret des dieux technologiques, il n’y a pas moyen de comprendre exactement comment la livraison de certaines informations plutôt que d’autres se réalise. L’utilisateur est tributaire de ce que les services veulent bien lui dévoiler à ce propos.

Pour réaliser une recherche vraiment décontextualisée de son propre « passé web », utiliser Tor Browser. Ce navigateur est plus connu comme la porte d’accès privilégiée au fameux darknet, mais peut tout-à-fait naviguer sur le Web visible (légalement). Le Tor Browser ne garde pas d’historique de navigation et limite au maximum les traces qui peuvent identifier l’utilisateur. Certains services web comme Google requièrent néanmoins un contrôle de sécurité minime (CAPTCHA ou autre) lorsqu’ils repèrent une visite provenant de Tor.

Si télécharger et installer Tor s’avère trop lourd pour une recherche rapide, il existe des moteurs de recherche généralistes qui limitent la transmission de données identifiantes (ou du moins prétendent le faire). Ma préférence va à Startpage, qui fournit en fait des résultats de Google, mais anonymisés.

Éviter les intermédiaires et tâcher d’aller au plus près des sources pertinentes est un principe de base d’une bonne recherche qui aide aussi dans la lutte contre la bulle de filtrage:

Pour limiter au jour le jour la bulle de filtrage, des contre-mesures passives sont possibles:

À l’exemple de refind cité plus haut, la bulle de filtrage peut être exploitée à son avantage:

Dans les navigateurs web courants comme Firefox, il est possible de créer des profils d’utilisateur distincts. On peut alors les utiliser pour des situations différentes. Par exemple, un profil pour un projet de recherche particulier, un autre pour une enquête, un troisième pour ses études. Il est utile de garder et de laisser des traces qui resteront dans leur profil respectif. Mais il faut rester conscient que certaines de ces traces dépassent le navigateur web: adresse IP (si pas de VPN/pas de Tor), adresse MAC… Et, plus prosaïquement, les simples données personnelles qui peuvent être recoupées d’un profil à un autre, par exemple si on utilise une même adresse e-mail pour se connecter à des services dans différents profils. Selon la nature et la sensibilité de ce que l’on recherche, une réflexion sur une compartimentation du travail de recherche doit précéder toute utilisation technique.

Ces conseils ne sont pas exhaustifs, mais sont une bonne base pour reprendre le contrôle sur l’utilisation de l’information.

Crédit photo: Tom Wachtel via Visualhunt.com / CC BY-NC-ND