Hall central du centre des congrès de Leipzig lors du 34c3

La 34e édition du Chaos Communication Congress (34c3) s’est tenue à Leipzig du 27 au 30 décembre 2017. Le nombre de conférences et d’ateliers fut conséquent, et la variété des sujets abordés confirme la volonté des organisateurs de faire de leur congrès plus qu’une « simple » manifestation de hackers. Avec plus de 15 000 entrées payantes, cette volonté d’ouverture semble fonctionner.

Pas de grande révélation cette année, plutôt une multitude de petites idées et de confirmations. Bien que le slogan du 34c3 fut TUWAT (traduisible par « AGIS! »), de manière générale, on en est resté au niveau du diagnostic. Les solutions aux problèmes identifiés ne sont pas aisées, sans doute.

Deux thèmes ont eut droit à plusieurs conférence: l’exploitation des données personnelles par des entreprises ou des structures étatiques et ses conséquences, et les avancées de l’intelligence artificielle.

Une traduction en données de pratiquement tous les aspects de la vie est en cours. Les données personnelles deviennent des marchandises vendues par des data brokers comme Axciom et Oracle. Elles sont utilisées pour de la prédiction, mais aussi pour de la prise de décision.

Le manque de transparence semble être une constante chez les acteurs qui disposent de moyens importants de collecte et d’analyse de données, que ce soit la police au Royaume-Uni, les entreprises chinoises travaillant pour le compte de leur gouvernement, ou les grandes plateformes de médias sociaux pour ce qui est de leurs critères de censure. S’ajoutent à cela:

- le risque de perte ou d’accès illégitime de tiers aux données personnelles collectées par ces instances (voir Equifax, Aadhaar, et bien d’autres encore).

- le risque de biais ou d’erreur dans l’interprétation de ces données, qui peut avoir des conséquences concrètes graves pour les personnes concernées (refus d’un crédit, d’un job, d’un appartement).

It’s not about your data, it’s about their derived data. – Tijmen Schep

Il existe une asymétrie de pouvoir entre d’un côté ceux qui ont la capacité de récolter des données en masse et d’agir à partir de ces données, de l’autre les personnes dont les données sont exploitées, qui subissent une perte de contrôle.

Sans connaître en détails ces pratiques, de plus en plus de gens s’en doutent bien. Ils/elles communiquent moins et se censurent par peur de conséquences négatives (social cooling). Par ailleurs, une étude représentative montre qu’une grande majorité des citoyens européens souhaite que les outils de communication soient respectueux par défaut de la sphère privée.

Un zoetrope en 3D exposé au 34c3

Les risques évoqués ci-dessus se retrouvent dans le traitement de telles données via l’intelligence artificielle. Les biais y sont omniprésents et mènent à de la « discrimination 2.0. ». Exemple: une recherche sur Google Images pour « three white teenagers » montrera trois jeunes souriants, alors que « three black teenagers » proposera trois portraits de jeunes suspectés de crime. Que ce soit voulu ou non, cela crée un effet de prophétie auto-réalisatrice.

Ces biais sont dus aux données qui influencent le modèle et/ou au modèle qui se répercute sur les données.

Exemple de biais de données: une étude chinoise affirme pouvoir reconnaître des criminels d’après les traits du visage. Or, les photos utilisées pour identifier « les gentils » sont tirées de dossiers de candidature, où les portraits sont sous leurs meilleurs jours, quand ils ne sont pas franchement retraités avec Photoshop.

Les biais de modèles se basent sur des suppositions simplifiées, qui ne sont souvent ni nommées ni vérifiées. Quand trop peu de contexte est disponible, respectivement trop peu de scénarios ont été testés, l’intelligence artificielle se base sur des suppositions: un médecin sera plutôt un homme qu’une femme, etc. Elle cherchera des corrélations, mais ne sera pas en mesure de déterminer causes et effets.

Ces types de biais existaient déjà dans la statistique. Tout cela n’est pas foncièrement nouveau, mais se trouve massivement renforcé par les capacités actuelles de calcul et les masses de données à disposition (Exemple: Google Mail a un milliard d’utilisateurs). La nouveauté est aussi que beaucoup d’argent est fait avec ces biais!

Artificial intelligence is powerful, but not mystical. – Katharine Jarmul

Connaître ces biais permet aussi de tromper une intelligence artificielle, par exemple en « empoisonnant » les données de test pour faire augmenter le taux d’erreur. Les applications pratiques: s’évader de la surveillance, tromper les systèmes de publicité, créer de fausses données personnelles, …

Que les données personnelles soient exploitées par de l’intelligence artificielle ou non, plusieurs intervenants mettent beaucoup (trop?) d’espoir dans les mécanismes légaux de défense induits par le règlement général sur la protection des données (RGPD), dont le respect sera bientôt obligatoire pour tout service agissant dans l’Union européenne. Apparemment, l’ordonnance y relative va dans la bonne direction.

Une marque de fabrique du Chaos Communication Congress est la dénonciation, preuves techniques à l’appui, de la sécurité défaillante voire inexistante d’infrastructures de services. Cette année, ce sont entre autre les bornes de chargement pour véhicules électriques et les applications mobiles des banques allemandes qui s’en sont pris pour leur grade.

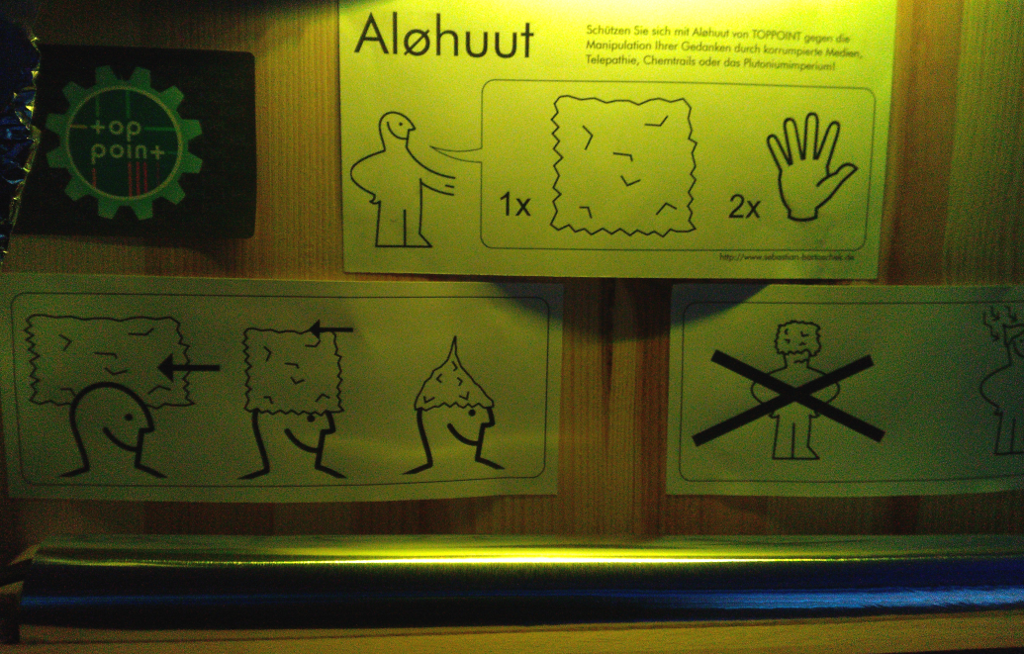

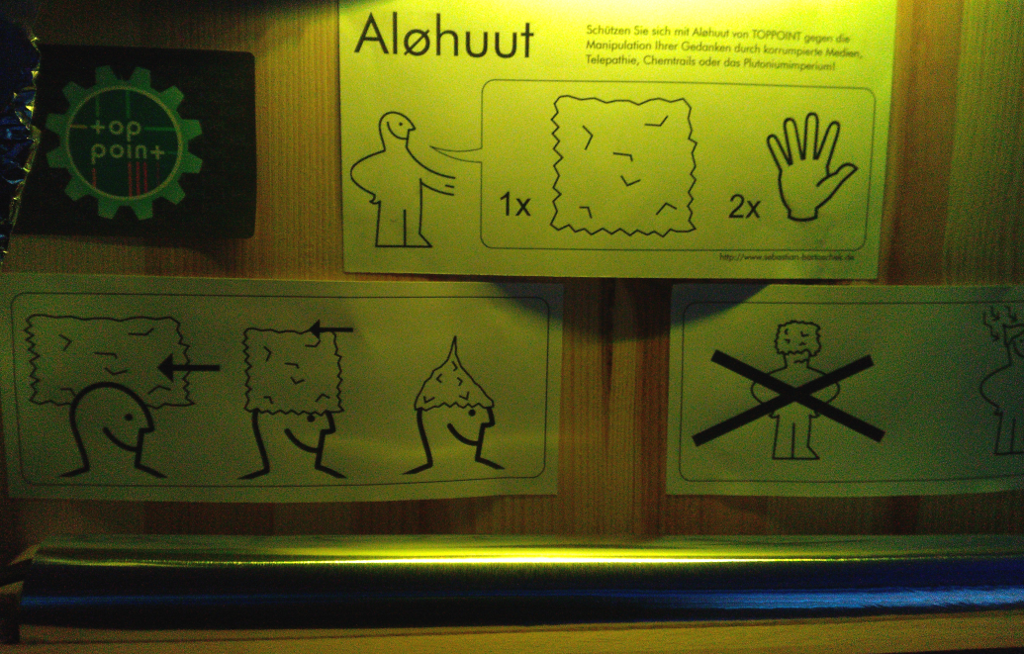

Instruction pour un chapeau en aluminium, inspirée par un grand fournisseur de meubles suédois

Quelques courtes infos (avec les vidéos des conférences dont elles sont tirées en lien):

The Chinese government do not count and think in years – they think in decades, at least. – Katika Kühnreich

Personnes, outils et organisations à suivre:

- Mahsa Alimardani pour la situation en Iran.

- Briar: une messagerie sécurisée de pair à pair, donc sans serveur. Requière une rencontre physique entre interlocuteurs pour le pairing de leurs appareils, ou un tiers de confiance. Pour l’instant uniquement pour Android.

- Le Cyber Independent Testing Lab (CITL) veut informer le grand public sur les risques associés aux logiciels, par exemple avec un code de couleur similaire à l’efficience énergétique des appareils.

- NeoPG: développement d’une alternative à OpenPGP/GnuPG 2 plus légère et plus efficace.

- Onlinecensorship.org: analyse de la censure sur les médias sociaux.

- Salamandra: détecter et localiser un microphone espion.

- Sebastian Schmieg pour la relation humains-logiciels.